Публикуем новую статью кандидата биологических наук, сотрудника Зоологического музея МГУ Георгия Любарского. Его публикация «Реформирование отечественной науки: от глобального — к частному» (ТрВ 9(28) от 12 мая 2009 г., с. 4-5) привлекла большое внимание читателей нашей газеты.

Публикуем новую статью кандидата биологических наук, сотрудника Зоологического музея МГУ Георгия Любарского. Его публикация «Реформирование отечественной науки: от глобального — к частному» (ТрВ 9(28) от 12 мая 2009 г., с. 4-5) привлекла большое внимание читателей нашей газеты.

Хочется думать, что всевозможные политические игры, экономические страсти и личные амбиции не имеют отношения к науке. С другой стороны, люди вокруг попадаются всё больше опытные, вплоть до цинизма, и все знают, что всё покупается, всё продаётся и глупо искать в подлунном мире абсолюта. Иные даже со значением проговаривают — «. и выше», но сейчас не об этом.

Удивительно, но многие люди, весьма интересующиеся положением дел в науке, не знают о механизмах её функционирования. Кроме всевозможных драк, интриг, скандалов и прочих житейских радостей, есть и ориентиры, позволяющие понять, как что работает. Это, например, научные индексы: импакт-фактор, индекс цитирования и индекс Хирша.

Импакт-фактор (IF) — численный показатель важности научного журнала. Считается очень просто: число упоминаний статей из журнала в других журналах, отнесенное к общему числу статей в журнале. Конечно, есть тонкости. Например, считается индекс за определенный срок, за два года. Если кого-то начинают цитировать через 30 лет — в индекс не попадает, хотя статья явно была нетривиальная. Другая тонкость — список журналов, включенных в подсчет индекса. Всего индексируется 8400 журналов из 60 стран, но в мире гораздо больше научных журналов, включены не все, но лучшие включены гарантированно. Да и средние тоже. Кроме того, считаются только цитирования в статьях, а не в письмах в редакцию, заметках, рецензиях и прочей научной мелкой периодике. Импакт-фактор считает Thomson Scientific (бывший Institute for Scientific Information — ISI), ежегодно результаты публикуются в Journal Citation Report.

Тот же Томсоновский институт считает и индекс цитирования (SCI) — число ссылок на данную статью какого-то автора. Есть несколько видов индекса цитирования, по разным областям знания. Многое можно увидеть, попросту затеяв поиск по сайтам http://scholar.google.com/ и http://quadsearch.csd.auth.gr/index.php?s=2&lan=1. Способов подсчета

индекса цитирования для данной статьи довольно много — зависит от того, в какую выборку ее включать и сколько изданий учитывать.

Чтобы узнать подобную характеристику для автора, а не для отдельной статьи, сейчас часто пользуются h-индексом — индексом Хирша (см. http://arxiv.org/abs/physics/0508025). Это — характеристика продуктивности, которая отражает число наиболее цитируемых статей автора и уровень их цитируемости. Индекс Хирша нужен, чтобы опираться на более тонкий показатель, чем просто общее число статей (которые никто не читает?) или общее число ссылок (у его друга, на которого он сам ссылается?).

Если расположить статьи автора в порядке цитируемости, получится список — от самой цитируемой до нецитируемой. Индекс Хирша -порядковый номер последней статьи в этом списке, число ссылок на которую не меньше этого порядкового номера. Например, на 15-ю по цитируемости статью — 19 ссылок, на 16-ю — 12 ссылок. Значит, индекс Хирша в этом примере равен 15 (очень прилично). А если этот индекс меньше 10, мало шансов урвать хорошую научную позицию. Хирш (а затем и другие) в своей статье показал, что этот фактор коррелирует с признанными показателями «успеха».

На все индексы влияют обычаи данной науки. Например, медики цитируют друг друга охотнее и обильнее, и потому индексы у их журналов выше математических и h-индексы медиков несколько выше, чем у математиков. Так что между науками индекс работает плоховато, в целом он зависит от продолжительности жизни ученого: в общем чем дольше живешь, тем больше ты опубликовал и тем больше на тебя ссылок. Умирать молодым плохо: «хирш» у Эвариста Галуа навсегда остался равен 2. Крупные ученые сейчас имеют индекс Хирша, равный 20-30-50 и выше. У некоторых чемпионов — вообще за 100. Есть база данных www.slac.stanford.edu/spires/, где можно посмотреть такие вещи для физиков.

Чего все эти замечательно простые показатели не делают? Они не отображают качества работы ученых и журналов. Почти совсем в общем-то не отображают. О качестве работ ученого могут судить те, кто занимается той же областью знания. И они собственной своею недарёной головой натыкаются на его ошибки или ощущают, как его работы им помогают.

Зачем же нужны индексы? Понятное дело, они совершенно не нужны коллегам ученого, хотя именно перед ним они могут хвалиться своим «хиршем». Тем, кто на самом деле знает, чего стоят работы ученого, индексы не нужны. Они нужны тем, кто не знает и не имеет возможности узнать. Надо просмотреть 150 резюме, а потом успеть… И тут-то и помогают индексы. В каких журналах печатается данный ученый, с какими импакт-факторами? А какой у него «хирш»? Ага. Примерно понятно, кто это такой и чего стоит.

По этим индексам оценивают кандидатов на то или иное место, решают вопросы карьеры, учитывают при раздаче грантов и вообще — ориентируются в бурном житейском море в условиях нехватки времени на получение качественной информации. Хирш-индекс не заменяет экспертной оценки компетентных коллег — напротив, он — слабое подобие этой оценки. Например, уровень неплохого кандидата наук или, к примеру постдока в естественных науках — примерно 5 по Хиршу. Это не значит, что каждый с пятеркой — хорош. И что кто-то с семеркой лучше. Индекс измеряет только то, что измеряет, — число ссылок в таких-то условиях. Но можно, если ничего не знаешь, учесть и это.

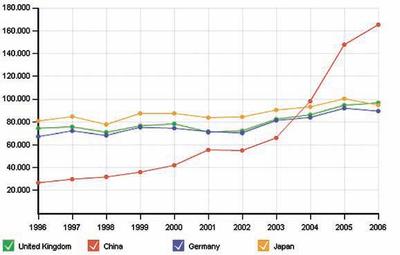

Тут надо сделать паузу и зафиксировать: в науке существуют «объективные меры», всеобщие, всемирные способы оценки работы научных журналов, отдельных ученых и целых стран. В самом деле, ведь Хирш-индекс можно и для целой страны посчитать, да уже и посчитан: http://opec.ru/docs.aspx?id=385&ob_no=86405.

Возникает вопрос: можно ли эти данные «накрутить», можно ли как-то так исхитриться, чтобы эти показатели были более благоприятны? Для автора, журнала или страны в целом.

Возникает вопрос: можно ли эти данные «накрутить», можно ли как-то так исхитриться, чтобы эти показатели были более благоприятны? Для автора, журнала или страны в целом.

Конечно, меры сами напрашиваются. Можно ссылаться на друзей, чтобы они ссылались на тебя (самоцитирования в этих индексах обычно не учитываются). А можно попытаться создать собственный индекс, который будет тебя благоприятнее учитывать. Ведь в каждом индексе есть свои детали и особенности — чуть иная база статей, с которой сравниваются результаты, чуть иная рамка подсчетов, временные границы, виды учитываемых работ… Есть разные индексы: свет клином не сошелся на одном Thomson, есть альтернативный ему Scopus. Их данные по некоторым параметрам отличаются чуть ли не вдвое.

Так что, конечно, есть разные варианты, более или менее честные, и даже вполне уместные и официальные. И есть этакий «феномен восточной науки». Говорить о нем надо очень деликатно, потому что чуть не так сказал — и получилось то, чего совсем не имел в виду.

Дело в том, что китайская наука растет с огромной скоростью. По числу публикаций Китай сейчас — следующий за США. Это вторая научная держава мира. Как при любом быстром росте, не обходится без накладок. Научные журналы мира завалены огромным количеством китайских работ, в том числе многие из них — не лучшего качества. При этом знатоки говорят, что несколько лет назад ситуация была хуже, уже за несколько лет «китайские статьи» стали чуть более вменяемы, а по прошествии времени, надо полагать, ситуация и вовсе исправится. Но пока — бывает.

Недавно в сети появился текст (www2.maidan.org.ua/news/index.php3?bn=maidan_osvita&key = 1249409309&action=view), в котором разбирается пример нескольких научных журналов по математическим наукам (Applied Mathematics and Computation, Communications in Nonlinear Science and Numerical Simulation, Computer Methods in Applied Mechanics and Engineering, Computers & Mathematics with Applications, Chaos, Solitons & Fractals, International Journal of Computer Mathematics). В эти журналы валом валят авторы из разных стран Ближнего Востока и из Китая. Насколько можно понять, в этих странах ученым платят в зависимости от их «показателей» — публикаций в журналах с приличным импактом. В этих журналах почти отсутствует рецензирование, в каждой статье очень обильное цитирование авторами себя и своих друзей. Все довольны — авторам идут деньги за публикации, у журналов повышается цитируемость, администрации Китая и других стран гордятся научным ростом.

Как уже говорилось, у формальных показателей есть свои слабые места. Хорошую статью пишут дольше, иногда статью начинают цитировать лишь спустя несколько лет. А индексы учитывают цитирования только «мгновенные», за два предшествующих года. Новаторов цитируют с запозданием, а обыденный мейнстрим — сразу. Так что «правильные» авторы теряют в показателях, а халтурщики растут — и сбивают цену индекса.

То есть все эти международные оценки и индексы можно развалить, и это уже делается. Значит, что же остается?

Тут надо вспомнить сопутствующие обстоятельства. Наука Китая — вторая по величине в мире, с чудовищно быстрым ростом, а Россия с некоторым трудом, но все же пока обгоняет Бразилию во втором десятке стран. В Китае ситуация с большим валом некачественных статей потихоньку (очень потихоньку) исправляется, в России — постепенно становится хуже. Мухлёж с индексами не остается незамеченным — вокруг не слепые сидят. Сделать можно очень многое. Можно изменить методики подсчетов и отсеивать не только самоцитирования, но и «круги цитат». Можно исключить из списков индексируемых журналов замаранные издания. И со временем, если этого не сделает одна служба (скажем, Thomson), то сделает другая (к примеру, Scopus).

Можно огорчаться и переживать по поводу фальсификации международных показателей рейтинга научных изданий. Можно, напротив, радоваться, что истории эти не покрыты мраком и есть надежда, что ситуация исправится. Но вообще-то это совершенно безразлично. Можно придумать несколько «своих» карманных индексов. Может быть, это даже и не очень плохо. Но главное — не забывать, что действительно важно.

Ходжу Насреддина как-то спросили: когда мусульманину приходится участвовать в похоронной процессии, где, по предписаниям ислама, лучше всего находиться — впереди погребальных носилок или позади? Ходжа ответил: это совершенно безразлично — впереди или позади, лишь бы не на самих носилках.