Завершаем публикацию исследования докт. биол. наук, профессора Александра Пудовкина о библиометрических показателях российской науки (начало см. ТрВ-Н, №№ 4,5 (73,74)). Для удобства читателей мы повторяем ряд рисунков из уже опубликованных частей цикла.

3. «Рейтинг научных учреждений», изданный группой SCImago

Таблица 6. Российские учреждения/университеты с импакт-показателем (НИ) 0.5 и выше (по данным отчета Ranking of Research Insctitutions: SIR World Report 2010).

| Ранг по НИ | Институт/Университет | Число публика-

ций1 |

Международное

сотрудничество2 |

Престижность

публикаций3 |

НИ4 |

| 306 | Institute for High Energy Physics | 1036 | 73.17 | 49.71 | 1.85 |

| 708.5 | 3-ий квартиль | 1.49 | |||

| 1261 | Alikhanov Institute for Theoretical and Experimental Physics | 2142 | 72.36 | 46.50 | 1.19 |

| 1416 | медиана | 1.12 | |||

| 1606 | Joint Institute for Nuclear

Research |

4625 | 76.61 | 35.85 | 1.02 |

| 2028 | Russian Research Centre

Kurchatov Institute |

2501 | 51.18 | 31.87 | 0.81 |

| 2029 | Moscow Engineering Physics Institute | 1323 | 41.72 | 23.89 | 0.81 |

| 2124.5 | 1-ый квартиль | 0.77 | |||

| 2470 | St. Petersburg State Polytechnic University | 1580 | 41.20 | 21.71 | 0.60 |

| 2471 | Moscow Institute of Physics

and Technology |

929 | 31.22 | 25.30 | 0.60 |

| 2512 | Novosibirsk State University | 1343 | 26.51 | 29.19 | 0.57 |

| 2532 | Russian Academy of Medical

Sciences |

4577 | 23.22 | 18.29 | 0.56 |

| 2566 | Lomonosov Moscow State

University |

18562 | 35.14 | 23.98 | 0.54 |

| 2586 | Russian Academy of Sciences | 87850 | 35.08 | 23.97 | 0.53 |

| 2629 | Saint Petersburg State

University |

5429 | 43.78 | 26.65 | 0.50 |

| 2630 | S. I. Vavilov State Optical

Institute |

862 | 26.80 | 16.36 | 0.50 |

| 2631 | St. Petersburg State

Electrotechnical University |

528 | 33.71 | 17.42 | 0.50 |

1 За 5 лет: 2004-2008 годы.

2 Процент статей, в которых среди авторов есть иностранцы.

3 Процент статей, опубликованных в журналах, входящих в верхние 25% списка журналов, ранжированных по показателю SCImago Journal Rank SJR indicator.

4 Показатель среднего цитирования отдельной статьи, выраженный в доле от среднемирового, с учетом нормирования по «возрасту» статьи и области знания.

На этом же сайте [1] есть ссылка на доклад «Рейтинг исследовательских учреждений» [2]. Это очень интересный материал, включающий данные за 5 лет (2004-2008 гг.) по 2833 исследовательским учреждениям со всего мира — университетам, государственным организациям типа академий наук, отдельным НИИ. Сюда включены те учреждения, которые опубликовали в 2008 г. не менее 100 научных работ. В этом списке оказалось 36 учреждений из России, включая РАН, РАМН, Московский и Санкт-Петербургский университеты (см. табл. 6).

В первом столбце показан глобальный ранг учреждения по «нормализованному импакту» (НИ), значения которого приведены в последнем столбце. НИ — это показатель среднего цитирования отдельной статьи, выраженный в доле от среднемирового, с учетом нормирования по «возрасту» статьи и области знания. Подробную информацию об этом показателе можно найти в Bibliometric Handbook for Karolinska Institutet [3]. Показатель «престижность публикаций» — это процент статей, опубликованных в журналах, входящих в верхние 25% списка журналов, ранжированных по показателю SCImago Journal Rank SJR indicator. Показатель «международное сотрудничество» -это процент статей с участием иностранных авторов.

Медианное значение НИ в этом списке из 2833 учреждений — 1,12, первый и третий квартили — 0,77 и 1,49. Видно (таблица 6), что лишь одно российское учреждение (Институт физики высоких энергий) имеет НИ выше 3-го квартиля, лишь 2 имеют НИ выше медианы и лишь 5 — выше 1-го квартиля. Остальные российские учреждения (их — 31) находятся в нижней четверти списка, ранжированного по значениям НИ.

| Ранг по

НИ |

Институт/Университет | Страна | Число публикаций1 | Международное

сотрудничество2 |

Престижность

публикаций3 |

НИ4 |

| 1 | Broad Institute of MIT and Harvard | USA | 861 | 48.32 | 92.68 | 6.02 |

| 2 | American Cancer Society | USA | 574 | 23.34 | 79.62 | 5.67 |

| 3 | Whitehead Institute for

Biomedical Research |

USA | 736 | 31.93 | 93.75 | 5.07 |

| 4 | Wellcome Trust Sanger

Institute |

GBR | 1424 | 63.27 | 89.96 | 3.82 |

| 5 | Novartis Pharma SA East

Hanover |

USA | 908 | 51.10 | 72.91 | 3.71 |

| 6 | Montreal Heart Institute | CAN | 864 | 41.32 | 77.43 | 3.69 |

| 7 | Kaiser Permanente | USA | 756 | 10.32 | 81.61 | 3.43 |

| 8 | Group Health Center for

Health Studies |

USA | 392 | 10.97 | 87.76 | 3.33 |

| 9 | Howard Hughes Medical

Institute |

USA | 6801 | 28.89 | 94.37 | 3.28 |

| 10 | California Pacific Medical

Center |

USA | 705 | 20.28 | 78.30 | 3.27 |

1 За 5 лет: 2004-2008 годы.

2 Процент статей, в которых среди авторов есть иностранцы.

3 Процент статей, опубликованных в журналах, входящих в верхние 25% списка журналов, ранжированных по показателю SCImago Journal Rank SJR indicator.

4 Показатель среднего цитирования отдельной статьи, выраженный в доле от среднемирового, с учетом нормирования по «возрасту» статьи и области знания.

Наши два знаменитых университета — Московский государственный университет им. М.В. Ломоносова и Санкт-Петербургский государственный университет — имеют очень скромные значения НИ — 0,54 и 0,50 и занимают 2566-е и 2629-е места в списке. Обе российские академии (РАН и РАМН) близки к этим университетам- НИ 0,56 и 0,53, 2532-е и 2586-е места в списке. Эти значения очень сильно контрастируют с мировыми лидерами в науке, приведенными в таблице 7, — российские академии (РАН и РАМН) и главные университеты (Московский и Санкт-Петербургский) имеют значения НИ почти в 12 раз меньше наиболее «импактных» учреждений.

Таблица 8. Продуктивность пяти национальных организаций (типа академий наук) — французской, китайской, немецкой, американской и российской — за 5 лет: 2004-2008 гг. (по данным отчета Ranking of Research Insctitutions: SIR World Report 2010).

| Академия | Число научных сотрудников* | Число публикаций | Публикаций на сотрудника | НИ** | ИИ*** |

| Chinese Academy of Sciences | 37500 | 130267 | 3.47 | 0.91 | 3.16 |

| Centre National de la Recherche Scientifique | 11500 | 125478 | 10.91 | 1.33 | 14.51 |

| Russian Academy of Sciences | 55000 | 87850 | 1.60 | 0.53 | 0.85 |

| Max Planck Gesellschaft | 4700 | 46576 | 9.91 | 1.81 | 17.94 |

| National Institute of Health | 6000 | 44278 | 7.38 | 2.23 | 16.46 |

* Данные взяты из Википедии.

** Нормализованный импакт — показатель среднего цитирования отдельной статьи, выраженный в доле от среднемирового, с учетом нормирования по «возрасту» статьи и области знания.

*** Индивидуальный импакт — суммарный импакт отдельного сотрудника, в среднем (произведение значений двух предыдущих столбцов).

Интересно сравнить продуктивность российских ученых с учеными других стан. В таблице 8 приведены данные для 5 учреждений, подобных Российской академии наук (данные о числе их сотрудников взяты из Википедии). Видно, что на одного научного сотрудника РАН за 5 лет пришлось 1,60 статьи, на сотрудника китайской академии — вдвое больше, 3,47 статьи, а продуктивность сотрудника CNRS составляет 10,91 статьи, т.е. почти в 7 раз больше, чем у сотрудника РАН. Если же попытаться получить интегральный показатель индивидуальной продуктивности ученого, учтя и количество статей, и их качество (через показатель НИ), то картина для болельщика за Россию получается совсем грустная (см. последний столбец таблицы).

Стоит заметить, однако, что на РАН приходится больше половины всех российских статей, включенных в базу данных Scopus: из 160523 российских статей 2004-2008 гг. 87850 приходится на РАН (54,7%). Интересно, что, если исключить все те 36 российских учреждений, которые включены в SIR World Report 2010, то оказывается, что на остальные (сколько их, сотни?) приходится лишь 21674 статьи, или 4335 статей в год. А в этих остальных учреждениях (в основном вузах) работает более 100 000 кандидатов и докторов наук. Где же и что же они публикуют?

4. Насколько объективны данные БД WoS и Scopus?

Представленные данные являются, конечно, не полными, всеохватывающими, а лишь выборочными. На них сильно влияет политика создателей БД: в силу разных обстоятельств они могут увеличивать число охватываемых журналов, проявлять значительную субъективность в выборе журналов. Поэтому временная динамика публикаций, представленная на рис. 1 и 3, отражает как действительный рост публикаций в мире, так и рост охвата базой данных WoS числа журналов. Но если рассматривать продуктивность и цитируемость российских авторов на фоне аналогичных данных для других стран, которых в той же степени затрагивают эта вы-борочность и субъективизм, то картина получается довольно объективная.

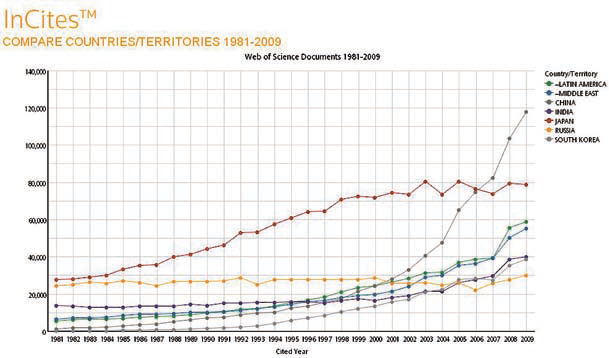

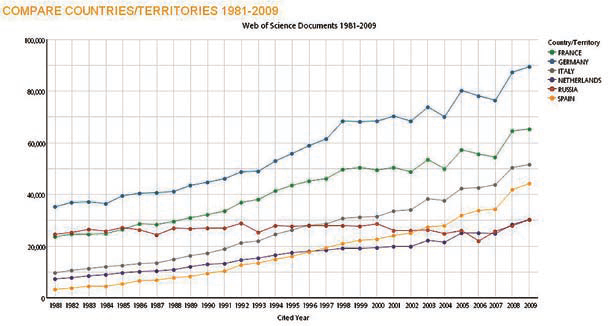

WoS и основанная на ней InCites охватывают примерно 10 000 журналов, а портал SJR, базирующийся на БД Scopus, охватывает 15 000 журналов, тогда как в мире публикуется, по некоторым данным [4], около 180 000 периодических изданий. Собственно научных журналов (по гуманитарным, социальным и естественным наукам)- около 50 000. Баз данных, охватывающих все научные журналы, не существует. В обеих БД, рассматриваемых в этой статье, представлены журналы из развитых англоязычных стран — США, Великобритании, Канады и Австралии, которые цитируются лучше большинства стран мира. Поэтому сравнение российских публикаций проводилось на фоне других неанглоязычных стан — Китая, Японии, Южной Кореи, Латинской Америки и Среднего Востока, а также европейских неанглоязычных стран — Франции, Италии, Испании, Германии, Нидерландов. Россия, при этом, очевидно, не является недопредставленной или как-то иначе дискриминированной.

В таблице 9 приведено количество журналов некоторых неанглоязычных стран, охватываемых БД Journal Citation Reports, которая составляет примерно 70% от БД WoS (для последней доступных данных по странам нет). В этой таблице Россия находится выше Китая, Южной Кореи, Индии, Италии. Замечу, например, что в этой БД лишь 68 индийских журналов (а российских — 123), в то время как индийский цитат-индекс [5] охватывает около 1000 индийских журналов. Поскольку большинство цитирований российских работ (около 70%) идет от нероссийских публикаций (см. таблицу 10, графа «доля самоцитирования») и поскольку этих публикаций много больше, чем российских (примерно 97,5 против 2,5%), то увеличение числа российских журналов в рассматриваемых БД вряд ли изменит картину.

Таблица 9. Число журналов нескольких неанглоязычных стран, охватываемых БД Journal Citation Reports (Reuter/Thomson).

| Страна | Число журналов |

| Германия | 512 |

| Япония | 200 |

| Франция | 177 |

| Россия | 123 |

| Китай | 114 |

| Италия | 100 |

| Индия | 68 |

| Ю.Корея | 64 |

| Испания | 60 |

| Тайвань | 25 |

По данным базы данных WoS, в 2008 г. доля российских публикаций составляла 2,41% от мирового количества, а по данным более представительной базы Scopus — ее доля была лишь 1,80%. Можно предположить, что если учесть все научные журналы в мире, то эта доля будет еще меньше. Так что низкие значения числа опубликованных российскими авторами статей, как и низкие показатели их цитируемости, не связаны ни с низким охватом российской периодики, ни с тем, что Россия не англоязычная страна.

Таблица 10. Цитируемость стран СНГ и бывшего соцлагеря (+ Вьетнам и Финляндия) среди 68 стран, опубликовавших в 2008 г. не менее 1000 статей.

| Ранг | Страна | Число

документов |

Число цитирований | Доля

самоцитирования |

Цитирований

на документ |

| 9 | Финляндия | 12,694 | 28,968 | 0.22 | 2.28 |

| 22 | Эстония | 1,389 | 2,389 | 0.23 | 1.72 |

| 25 | Венгрия | 7,107 | 11,881 | 0.20 | 1.67 |

| 31 | Вьетнам | 1,315 | 2,005 | 0.18 | 1.52 |

| 32 | Чехия | 10,824 | 16,158 | 0.28 | 1.49 |

| 34 | Словения | 3,596 | 4,823 | 0.26 | 1.34 |

| 37 | Болгария | 2,906 | 3,552 | 0.20 | 1.22 |

| 40 | Польша | 21,584 | 25,698 | 0.29 | 1.19 |

| 44 | Словакия | 3,780 | 4,171 | 0.24 | 1.10 |

| 45 | Литва | 1,953 | 2,117 | 0.38 | 1.08 |

| 53 | Сербия | 3,186 | 2,955 | 0.35 | 0.93 |

| 57 | Хорватия | 3,590 | 3,232 | 0.26 | 0.90 |

| 59 | Румыния | 6,821 | 5,599 | 0.31 | 0.82 |

| 60 | Россия | 32,164 | 23,982 | 0.31 | 0.75 |

| 66 | Украина | 6,201 | 4,086 | 0.31 | 0.66 |

| 67 | Беларусь | 1,317 | 836 | 0.24 | 0.63 |

Таблица 11. Цитируемость стран СНГ (+ Северная Корея), опубликовавших в 2008 г. менее 1000 статей.

| Страна | Число документов | Число цитирований | Цитирований на документ |

| Армения | 559 | 782 | 1.40 |

| Сев. Корея | 18 | 25 | 1.39 |

| Молдавия | 278 | 334 | 1.20 |

| Монголия | 186 | 208 | 1.12 |

| Албания | 83 | 87 | 1.05 |

| Грузия | 538 | 550 | 1.02 |

| Узбекистан | 376 | 289 | 0.77 |

| Азербайджан | 508 | 300 | 0.59 |

| Казахстан | 299 | 147 | 0.49 |

| Туркмения | 5 | 2 | 0.40 |

Это хорошо видно, если посмотреть, как цитируются страны СНГ и страны бывшего соцлагеря. Литва и Эстония имеют больший показатель цитируемости, чем Россия (1,72 и 1,08 против 0,75; все бывшие соцстраны имеют более высокое цитирование (таблица 10). В таблице 11 приведены аналогичные показатели по тем странам СНГ и соцлагеря, которые опубликовали в 2008 г. совсем мало статей (меньше 1000). Большинство даже этих стран имеет цитируемость выше российской.

У многих россиян сохраняется представление, сформированное еще в 60-х и 70-х годах — о том, что Россия — великая научная держава (недавно создана водородная бомба, запущен спутник, первый космонавт, советские суда бороздят воды Мирового океана, изучая жизнь глубин, недоступную ученым других стран). И действительно, в 1960-70-е годы СССР был 3-й или 4-й страной в мире по числу научных публикаций (после США, Великобритании и Германии). Сейчас это далеко не так: в 2008 г. Россия находилась на 15-м месте по числу публикаций (после Южной Кореи, Нидерландов и Бразилии, см. таблицу 1), и ее доля составляла менее 1,8 % от числа мировых публикаций, учитываемых базой Scopus. По числу цитирований в 2008 г. Россия была на 24-м месте (таблица 4), ниже Финляндии и Польши, а по средней цитируемости — на 42-м месте, после Ирана, Китая, Румынии (таблица 3).

1. Ranking of Research Institutions: SIR World Report 2010. www.scimagojr.com/news.php?id=147

2. http://ki.se/ki/jsp/polopoly.jsp?a=17742&d=1610&l=en

3. Tenopir C. Online scholarly journals: How many? Library Journal. 2004. V.129. P. 32.

4. Indian Citation Index www.indiancitationindex.com/ici.aspx?target=aboutICI

1. «По данным базы данных WoS, в 2008 г. доля российских публикаций составляла 2,41% от мирового количества »

ВВП России составляет 2.3% процетна от мирового

2. «продуктивность сотрудника CNRS составляет 10,91 статьи, т.е. почти в 7 раз больше, чем у сотрудника РАН»

Лукавые цифры. Сотрудники CNRS не пишут по 6 статей в год ( 10 статей за 5 лет при учете того что у каждой статьи в среднем 3 автора дает 6 статей на человека в год). Студенты, аспиранты, пост-доки, иностранные визитеры не являются сотрудноками CNRS даже если там работают.

3. Подушевое ВВП России применно в 5 раз меньше чем в западных странах. Госрасходы на науку в долях ВВП у нас даже больше чем на западе. Заметного улучшения здесь ждать не приходится. С точки зрения научных результатов мы находимся там где нам и надлежит быть. Никакими реорганизациями науки законы природы не отменишь.

> Лукавые цифры. Сотрудники CNRS не пишут по 6 статей в год ( 10 статей за 5 лет > при учете того что у каждой статьи в среднем 3 автора дает 6 статей на человека > в год). Студенты, аспиранты, пост-доки, иностранные визитеры не являются >сотрудноками CNRS даже если там работают.

Не очень понятная у Вас арифметика. Конечно, у большинства статей много соавторов, но пишет обычно один человек, сотрудник CNRS, а студенты, аспиранты и пр. лишь приписываются. Так что на «пишущего» сотрудника приходится 2.2 статьи в год, вполне реалистично. При оценке продуктивности нужно не суммировать число статей по всем сотрудникам (как часто делается в наших отчетах), а брать число статей, выпущенных данной лабораторией или институтом, иначе получается искусственное завышение числа публикаций.

В любом случае, приведенные цифры вполне сравнимы, получены одинаковым путем.

Вот мой «родной» институт LAPTH куда я езжу на кормление.

Штат (CNRS) 22 человека. За 5 лет 231 статья, процитированы 3277 раз (WoS).

То есть по 11 статей на человека, как в Вашей статье и написано. 14 ссылок

на статью. Но когда я на смотрю на каждого сотрудника по отдельности, то оказывается, что в среднем каждый пишет по 2 статьи в год (от 5 до 0).

Естественно, в соавторстве с аспирантами, постдоками, визитерами. А у нас с кем работать? Аспирантов мало, постдоки — они-же мнс — сотрудники РАН.

Ваша цифра для РАН: 1.6 за 5 лет. У работы в среднем 3 автора. То есть один человек пишет в год 1.6*3/5 = 0.96 — одну работу. Хуже чем в CNRS, но не в 7-же раз! Сотрудников CNRS, наверное, надо сравнивать со старшими и ведущими сотрудниками РАН.

В моем московском институте, НИИЯФ МГУ, 400 научных сотрудников,

за 5 лет написано 1600 работ с ообщей цитируемостью 8000 (WoS). То есть 4 статьи на научного сотрудника за 5 лет. Средняя цитируемость — 5. А теоретический отдел ОТФВЭ в котором я работаю от LAPTH мало отличается: 26 сотрудников, 253 статьи, процитированы 2200 раз. Могло-бы быть и хуже.

Ваша арифметика определенно представляется мне «лукавой». Количество авторов в статье к этой статистике не имеет никакого отношения. Пусть в лаборатории имеется N сотрудников и они произвели Y статей. Тогда в среднем на каждого приходится y=Y/N статей. В действительности все статьи могут написаны быть в соавторстве всей группой из N человек. Тогда у каждого в отдельности будет Y статей, но в среднем на человека будет приходиться Y/N статей. А могут они писать в одиночку, без соавторов, тогда каждый напишет в среднем Y/N статей, то есть столько же, сколько в среднем по группе. То же самое будет, если в статьях будут соавторы, но из других учреждений. Тогда, все равно, в среднем на сотрудника данной группы будет приходиться Y/N статьи. То есть в этих расчетоах все ясно, все прозрачно. Но главное, что расчеты средней продуктивности делались одинаково для всех сравниваемых учреждений. А с тем, что у сотрудников CNRS много потенциальных соавторов (визитеры, аспиранты), а у сотрудников РАН таких соавторов меньше, согласен. Это один из факторов низкой продуктивности РАН. Также очевидно, что НИИЯФ сильно отличается по продуктивности от большинства институтов РАН.

> Ваша арифметика определенно представляется мне «лукавой».

Вопрос о знаменателе: на мой взгляд «Сотрудники CNRS» — соответствуют «старшим и ведушим РАН». А если-бы Вы стали настаивать на том что сотрудники CNRS соответствуют всем сотрудникам РАН ( ~100000) то результаты бы-ли бы в два раза хуже тех что Вы представили. Мотор науки — постдоки — у нас они в РАН у них вне CNRS. Какая-то часть РАН — гуманитарные науки. Их надо исключить из рассмотрения для аккуратного сравнения.

>Также очевидно, что НИИЯФ сильно отличается по продуктивности от большинства институтов РАН.

Посмотрите ФИАН(РАН), ИЯИ(РАН) , физический и химический факультеты МГУ. Ожидаются примерно те-же результаты что и в НИИЯФ. МИАН(РАН), Ландау(РАН) — должно быть много лучше потому что это теоретические институты.

По поводу «знаменателя» Вы, возможно, правы. Проводить детальное сопоставление академий (или подобных им организаций) разных стран просто невозможно — нет легко доступной информации. Не думаю, что нужно исключать гуманитариев — они доже пишут научные статьи. Но факт остается фактом — у нас мало пишут, пишет не особенно хорошо, публикуют не там, где стоило бы. Конечно, есть исключения, есть «передовики». Но в среднем, ситуация очень грустная…

ИНСТИТУТ статьи(WoS,5лет)/нс цитируемость

Физфак МГУ 3764/720= 5.2 3.0

Химфак МГУ 4173/1100=3.8 3.1

НИИЯФ МГУ 1600/400 =4 5

ФИАН 3256/800= 4.1 4.2

им. Ландау 1333/74 = 18 4.8

В число научных сотруднитов факультетов включены преподаватели,

но не включены аспиранты. Цитируемость приведенная в таблице — это средняя цитируемость за 5 лет. То есть 5 означает что статьи написанные 5 лет назад были в среднем процитированны 10 раз. На мой взгляд совсем не прохо для средних.

Данные по публикациям получены по запросам

ad=(Lomonosov SAME Phys* NOT Nucl*)

ad=(Lomonosov SAME Chem*)

ad=(Lomonosov SAME Nucl*)

ad=(Lebedev)

ad=(Landau)

Успехи гуманитарных и общественных наук конечно характеризуются числом

статей. Но я сомневаюсь что WoS видит те журналы, куда наши гуманитарии

посылают свои статьи. 70 лет изоляции должны сказаться. Поэтому я бы вынес за

скобки гуманитарные и общественные науки при попытке анализа ситуации в

РФ/РАН.

Да, выглядит неплохо. Правда я не понимаю, почему Вы так считаете: «То есть 5 означает что статьи написанные 5 лет назад были в среднем процитированны 10 раз.»

Мне это совсем не очевидно.

Повторил Ваш поиск для статей, написанных 5 лет назад (2006) авторами с Физфака (Lomonosov SAME Phys* NOT Nucl*) и получил следующие цифры: число статей 798, средняя цитируемость 5.42 (а совсем не 10). Кстати, 5 самых цитируемых работ, найденных при таком запросе, относятся не к Физфаку, а к Институту Белозерского: Moscow MV Lomonosov State Univ, AN Belozersky Inst Physicochem Biol, Moscow 119899, Russia

По поводу работ гуманитариев. Да, наверное, их стоило бы анализировать отдельно.Но данных таких нет. Думаю, что вряд ли это изменило бы картину. По поводу того, что WoS не видит тех журналов, где печатаются российские гуманитарии, согласен. Но, вот, ссылки на них WoS вполне видит (правда, для этого нужно искать по первому автору, то есть быстрый, «халявный» поиск, который нам доступен, не позволяет сделать этого). Ведь ссылки совсем не обязательно в российских журналах должны быть. Ну, это если в мире читают российских гуманитариев. А если их не читают, так и вопроса нет.

Да, c физфаком я немного ошибся. Я привел ключи отбора потому что полной уверенности не было. OK, надо добавить «NOT Bio*» тогда среднее число работ за 5 лет будет 3.3 и цитируемость 2.5.

Первые 3-5 лет рост цитируемости одной статьи растет линейно. Поэтому 5 ссылок в среднем за 5 лет — значит 10 ссылок за работы 5-летней давности. Вы получили

5.4 для «физфака», но для него средняя цитируемость была 3, те ожидалось 6.

Средняя цитируемость 5 была у НИИЯФа. Работы 2005 года цитируются в среднем 9.7 раз, 2006 год — 8.8. То есть с 10% ошибкой моя формула работает. А если учесть что год публикации это пол года цитирования, то теория с практикой полностью совпадут.

«Cited reference search» конечно никто никогда не использует. Слишком трудоемко. С какого бодуна Scientific.ru использует этот метод — понять невозможно.

Scientific.ru приводит данные о распределении ученых с высокой цитируемостю по институтам РФ. Если это данные дополнить данными о числе научных сотрудников то сразу станет ясно WhoIsWho. Только где их взять?

Все эти цифры вообще имеют отдаленное отношение к собстенно научной работе. Просто ловкость научных рук.

1) В европе, США, Канаде, Японии и т.д. сотрудник врашается в более полноценной научной среде и может лечге «получить» соавторство в хороших статьях. Просто более эффектиный менеджмент в части «приписыания».

2) Значительная часть статей выше-упомянутых стран сделана в том числе выходцами их СНГ, и в шапке статьи упомянуется «родное» заведение.

3) Вследствие неправильной «ориентации» научной мысли в РФ львиная доля энергии направляется на подготоку «мусорных» статей, то есть статей для галочки в сборники, журналы местного разлива, то есть просто в «мусорное ведро»

4) что такое число научных сотрудников РФ понять вообще невозможно. Есть подозоения, что это цифра с потолка, чтобы клянчить бюджет. В каких-то странах считают полноценных ‘scientific staff members’, а где-то оперируют списками «мертвых душ».

Слишком общее, неконкретное замечание. О каких цифрах Вы говорите? В моей заметке много самых разных цифр. Скажите конкретнее, тогда пообсуждаем.

1. Эффективный научный менежмент, конечно, важный элемент западной науки.

А при чем тут приписывание? Ведь же прежде всего надо создать то к чему приписывать.

2. Это неправда. Научный потенциал СССР был, конечно, заметен на мировой арене, но никогда не доминировал.

3. А в рассматриваемой статье «мусорные статьи» написанные для журналов «местного разлива» и не учитываются.

4. http://www.csrs.ru

На замечание Пухова от 23 апреля: «Cited reference search» конечно никто никогда не использует. Слишком трудоемко. С какого бодуна Scientific.ru использует этот метод — понять невозможно.

«Cited reference search» хорош тем, что с его помощью можно видеть цитирование работ, не охватываемых WoS — книг, статей в сборниках и во всяких малоимпактных журналах. Многие авторы в зоологии, ботанике, геологии, в инженерных науках и пр. преимущественно публикуются в таких изданиях. Этот поиск трудоемок, но каждый научный сотрудник легко может сделать его для своих работ и отдать результаты в администрацию своего института. Тогда данные о цитировании будут честными и вполне сравнимыми. Иначе наблюдается очень сильный перекос в отношении авторов из «медленно движущихся областей», а суммарно таких авторов где-то половина от всех научных сотрудников.

Я сам, положим, ссылки в WoS на свои неопубликованные работы найти могу, но никто более. Потому что всех авторов при таком поиске не видно. Ясли я первый или единственный или суперизвестный ученый, то мое имя будет упомянуто при цитировании и Cited References Search ссылку найдет. Если нет — то нет. Реально надо перебирать всех соавторов.

Далее, большинство ссылок полученных Cited References Search не имеет даты. Обычно дата зашифрована в номере препринта и отдельно при цитировании не приводится. Получаются курьезные ситуации как представление Фаддеева ЛД в WhoIsWho: Глубина поска в реферируемах журналах ограничена 1986(?) годом, а основные работы Фадеева были сделаны до этой даты. А нежурнальные ссылки идут без даты! Вот так и получаются великие ученые известные по неформальным ссылкам.

Ссылки на одну и ту-же работу не из списка WoS могут быть представлены по разному. Поэтому одна и таже работа в Cited References Search представлена как множество разных.

Cited References Search не позволяет установить место работы поэтому разобраться с однофамильцами практически невозможно.

А главное — это очень трудоемко. WhoIsWho уже 9 месяцев обновляет свои списки. И доверия к этим спискам нет. А откажись они от Cited References Search и вся работа легко компьютеризивуется и делается за пару недель.

Ну,хорошо. Составлю я сам свой список цитирований и отнесу его в администрацию института как советует Александр Пудовкин. Ну и куда они меня пошлют с этим списком который они реально проверить не могут? ….А мой коллега не принесет, у него нет доступа. И что он мне скажет?… Между прочим администрация моего института закупила доступ к WoS и взяла на работу человека который будет эти данные обрабатывать. Зачем ему мои бумажки?

Поэтому я порекомендовал-бы WhoISWho экономить свое время и на основе Advanced Search быстро получать достоверные данные. Не надо делать то, что реально сделать невозможно.

Да, использавать Citation Search может либо сам автор, либо тот, у которого есть список работ (с указанием всех авторов) человека, для которого производится поиск. Раз Ваш институт имеет специального работника, обязанность которого проводить цитат-анализ, то он и может проверять результаты поиска, который сделали для себя все сотрудники. Ему лишь нужно будет сдать списки своих работ и он будет либо выборочно (когда есть сомнения), либо тотально проверять. Обычно данные нужны лишь за последний 5-летний период, так что работ не так много и провести анализ будет не особенно трудно. Я больше 30 лет проработал в институте, где основная масса сотрудников были зоологами, альгологами, гидробиологами, геологами, географами (Институт биологии моря во Владивостоке). Использование Advanced Search для них было дискриминационным, так многие журналы, где они печатались (даже японские и южно-корейские) не охватываются WoS. Такой цитат-анализ лишь дискредитировал саму идею его использования для оценки продуктивности научного работника. Сам основатель всей «цитат-мудрости» Юджин Гарфильд называет такой быстрый, но очень неполный анализ «quick and dirty» и предостерегает от его использования. Но в отношении списков WhoIsWho я согласен, что Citation Search не подходит (прежде всего из-за омонимии).

На мой взгляд для того что-бы разoбраться с текущим состоянием российской науки нужны данные по отдельным институтам, включая число научных сотрудников,

в том числе без ученой степени. Кажется почти половина научных сотрудников РАН не имеет ученых степеней. Причем этот процент не зависит от возраста (www.csrs.ru). Если так, то что сравнивать РАН с CNRS? По разным причинам WoS не покрывает всю российскую науку. Надо сравнивать с помощью WoS только те части науки где сигнал от WoS наблюдается. Ну и конечно при анализе нельзя забывать что Россия страна бедная, BBП на душу населения маленький ожидать чудес оснований нет.

ВВП и публикации.

В таблице 8 приведены данные по числу статей и цитируемости для таких сходных организаций как РАН, академия наук КНР и CNRS. Давайте для сравнительной характеристики умножим число статей на индекс цитирования и разделим на ВВП

Китай: 130267*0.91/5745 = 20

Россия: 87850*0.53/1476 = 31

Франция: 125478*1.33/2555 = 65

Мы оказались между Францией и Китаем, как и должно было быть из высших географических соображений. При этом, заметьте, что у нас на науку идет 1.03% ВВП, а во Франции 2.08%.(http://polit.ru/lectures/2011/03/31/dolls.html)

Для более точного сравнения надо знать какая часть фундаментальной науки приходится на CNRS и академии наук РФ и КНР. Про РАН мы знаем — примерно половина.

Так есть ли повод для грусти кроме того что живем мы в стране бедной и вклад бизнеса в финансирование науки очень маленький? К федеральному правительству особых претензий нет: 0.65%ВВП у нас, 0.80%ВВП у Франции, 0.75%ВВП — США,-

хотя, конечно, резонно требовать от правительства РФ подтянуться до уровня западных стран.

Конечно, для грусти повод есть — мало статей публикуют в России и не очень хорошего качества (в среднем). Скоро в мировом потоке публикаций российские статьи вообще будут незаметны. Конечно, роль плохого финансирования существенна в этой ситуации. Но не только в суммарном финансировании дело. Однако факт остается фактом — наука чахнет в России.

Ваши расчеты не убедительны, потому что, как правильно вы отметили, мы не знаем, какая доля национальной научной продукции продукции приходится на китайскую АН и на французский CNRS. Думаю, много меньшая, чем на РАН

WoS, 2010

cu=(Russia) =>30758

cu=(France) =>83449

Отношение 2.7

Для финансирования отношение 3.5, т.е. у нас одна работа на 30% дешевле.

Индекс цитируемости сравнить не могу, слишком много работ. Но тут вопрос простой: надо 30% сэкономить и использовать для участия российских ученых в

международных конфененциях. Без этого никакого цитирования не будет.

По-моему, Вы излишне много внимания обращаете на соотношение финансирование/число работ. Самое печальное то, что российские работы не читают — по цитируемости российские работы находятся на 60-ом месте, ниже Хорватии и Румынии (см. Табл.10). Вряд ли в этих странах на науку тратится больше, чем в России. Меня никак не греет, что российские работы обходятся на 30% дешевле французских. Важно, что они мало кому нужны.

Румыния: население в 7 раз меньше, ВВП в 7 раз меньше, работ в WoS в 7 раз меньше, цитируемость примерно такая-же. Как полопали так и потопали!

Сравниваю цитируемость Франция/Россия по статьям 2005 года: Biochemistry 21/10; Particles and Fields 13/10. Я бы не сказал что 10 цитирований на статью означает что статьи оказались никому не нужны.

Вот у меня в руках статья довольно известных западных авторов. В работе 21 ссылка. Но вне Introduction только 5, из коих 3 — самоцитирование. То есть существенное цитирование составляет порядка 10-20% от полного. А остальное просто приводится во введении для политеса и декларации того что автор с литературой знаком.

Если мы хотим поднять цитируемость российских статей, то надо выделить деньги

на участие в международных конференциях что-бы сделать российские работы

известными. Для этого нужны весьма небольшие деньги по сравнению с заработной

платой. Конечно есть много факторов которые приводят к ухудшению качества российских работ : а) второсорное оборудование вынуждает делать второсортные

работы; в) Нет денег на создание межинститутских научных коллабораций

которые дают работы с максимальной цитируемостью; г) возрастной состав: д)

ментальность. Но покуда работы не представляются на конференциях — откуда ждать цитирования?

Да и плавание в main stream не всегда хорошо. Как правило обладатели высоких рейтингов по цитируемости подобны флюсу(Прутков) — полнота их одностороняя.