Многие важные решения последних лет по организации научных исследований в России принимаются весьма поспешно. Примером служит стенограмма заседания правительства РФ, на котором членам кабинета министров и президенту РАН был неожиданно представлен проект закона об упразднении Российской академии наук [1]. Весьма характерно то, что на этом заседании не было озвучено ни количественных параметров, ни независимых экспертных оценок, демонстрирующих низкую результативность институтов Российской академии наук в сравнении с другими научными организациями России. Только после запуска реформы РАН Министерство образования и науки приступило к созданию системы оценки эффективности научных организаций — Федеральной системы мониторинга результативности деятельности научных организаций, выполняющих научно-исследовательские, опытно-конструкторские и технологические работы (ФСМНО) [2]. В похожем стиле действует и Федеральное агентство научных организаций (ФАНО), которое сначала запустило программу реструктуризации подведомственных учреждений и только после этого позаботилось о методике оценки их эффективности [3], использующей формальные количественные (средние, удельные или интегральные) хранящиеся в ФСМНО показатели. Создается впечатление, что направленные на реформу научной сферы указы, законы и приказы выпускаются без должной аналитической работы. Однако такая подготовительная работа исключительно важна, во-первых, для обоснования принимаемых решений и, во-вторых, для предсказания результатов планируемых преобразований.

Отсутствие всесторонней публичной экспертизы проводимых реформ можно связать со следующими обстоятельствами. Во-первых, такие преобразования могут быть направлены на удовлетворение амбиций вхожих в высокие кабинеты личностей и выгодного персонально им дележа пирога научного бюджета РФ. В такой ситуации достоверность оценки эффективности научных организаций неминуемо уходит на второй план, а независимость и объективность системы оценки начинает мешать реформаторам. Во-вторых, нельзя исключить, что разработанная ФАНО система оценки научных организаций [3] позволит манипулировать формальными числовыми показателями организаций, произвольно их интерпретировать с целью оправдания значительных сокращений научного персонала и даже ликвидации отдельных научных институтов в нынешних условиях экономии бюджетных средств. Подобные опасения в отношении методики ФСМНО неоднократно высказывались коллегами как ранее [4,5], так и совсем недавно [6].

Соглашаясь со сказанным в [4–6], я не ожидаю, что Минобрнауки и ФАНО откажутся от использования формальных показателей результативности для оценки научных организаций. Стремление использовать такие показатели происходит от непонимания управленцами получаемых в подведомственных учреждениях научных результатов по существу. Отсюда возникает соблазн, не вникая в суть результатов, описать их средними по каждому институту значениями для удобства подсчета и доклада наверх по вертикали власти. При этом сложность, многоплановость и разнообразие научных результатов заменяется формальными показателями. Научные публикации, описания сущности научных достижений и результатов сводятся к таблицам количества опубликованных статей без оценки их уровня, средним и удельным значениям, суммарным показателям, графикам прироста количества публикаций по кварталам и годам.

На средние значения показателей результативности ориентирован ряд официальных документов Минобрнауки и ФАНО. Например, в пресс-релизе Совета по науке при Минобрнауки от 05.02.2015 сказано [7]: «Совет отмечает необходимость сохранения в п. 13 положения об аттестации соотнесения показателей аттестуемого работника либо со средними показателями по референтной группе организаций, либо со средними показателями для данного института». Газета «Поиск» в № 40 (2015) от 5 октября 2015 года сообщала о решениях НКС ФАНО [8] относительно критериев определения лидеров в сети подведомственных ФАНО научных организаций, следуя которым организация может быть признана лидером только в том случае, если ее показатели значительно превышают средние по референтной группе. При этом в официальных документах Минобрнауки и ФАНО нет сведений о том, как результативность или успешность научных работников распределена внутри научных коллективов.

В 1926 году Альфред Лотка [9] исследовал распределение продуктивности физиков и химиков в виде количества опубликованных ими статей за 10 лет. Сформулированный им эмпирический закон гласит, что число xk ученых, каждый из которых написал k статей, можно аппроксимировать зависимостью x1*k —α со значениями α, близкими к 2. Следуя этой зависимости, можно ожидать, что если в научном коллективе есть 100 ученых, которые написали по одной статье за определенный промежуток времени, то в этом же коллективе будут примерно 25 других ученых, которые написали по две статьи каждый, будет около 11 ученых — с тремя статьями, шесть ученых — с четырьмя статьями и т. д. Наконец, можно ожидать, что будет один автор с 10 публикациями. За прошедшие с момента публикации статьи [9] 90 лет справедливость закона Лотки была подтверждена многими десятками работ, где значения показателя α от 1,4 до 3,9 были использованы для описания аналогичных наборов данных. В работе [10] изучалось распределение не количества публикаций, а их качества, которое можно связать с количеством цитирований каждой из работ. Было показано [10], что вероятность P(k) того, что публикация по физике высоких энергий, которая индексируется в базе SPIRES (ныне INSPIRE), получит k цитирований, пропорциональна k —α, причем α = 1,2 для совокупности работ с числом цитирований менее 50 и α = 2,3 для совокупности более популярных работ.

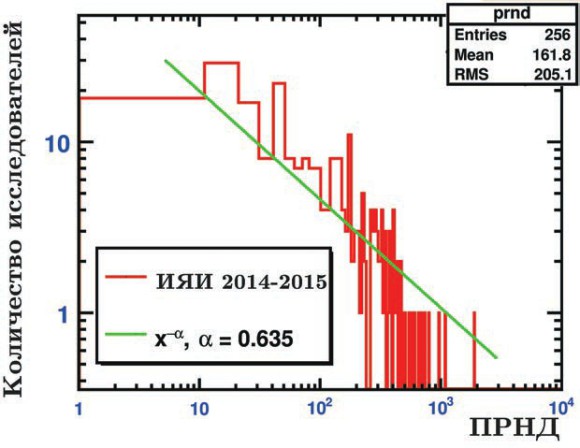

Можно спорить о том, какая именно мера — количество публикаций или количество цитирований статей — наиболее достоверно отражает продуктивность каждого научного работника. В ИЯИ РАН для этого используется показатель результативности научной деятельности (ПРНД), способ вычисления которого утверждается ученым советом института. ПРНД выражает формальную результативность научного работника за последние два года в виде баллов, которые начисляются за каждую публикацию в реферируемых журналах в количестве 30*I/А для международных журналов и в количестве 60*I/A для российских, где I — импакт-фактор журнала, а A — число соавторов. Разумеется, таким способом конкретный научный уровень недавно вышедшей из печати работы можно оценить лишь косвенно, через импакт-фактор опубликовавшего ее журнала, так как еще не написаны работы, которые впоследствии ее процитируют. Помимо статей баллы можно получить за доклады на международных и российских конференциях (кроме совещаний коллабораций); публикации в трудах конференций; монографии, патенты, промышленные образцы, чтение лекционных курсов, научное руководство студентами и аспирантами.

На рис. 1 представлена гистограмма частотного распределения величин ПРНД сотрудников ИЯИ РАН, построенная на основе данных за 2014–2015 годы, доступных на сайте института. Интересно, что распределение в целом можно уверенно аппроксимировать уже знакомой функцией x —α, где α = 0,635. Важно отметить, что распределение ПРНД за 2011-2012 годы также неплохо описывается х —α, но с α = 0,881, и эта разница, по-видимому, связана с некоторым изменением правил расчета ПРНД в 2016 году. Зависимость вида х —α характерна для ИЯИ РАН как многопрофильного научного центра. Широкий диапазон изменений ПРНД связан не только с различной индивидуальной результативностью сотрудников, но и в значительной степени определяется спецификой и средой их деятельности: большая международная коллаборация, настольный эксперимент, теоретические исследования, обеспечение работы научной инфраструктуры (ускорителя, нейтринных детекторов). Это наблюдение подтверждается тем, что более однородная результативность (и, соответственно, малые значения α) получается для отдельных подразделений ИЯИ РАН, поскольку заметная часть работ обычно публикуется совместно с коллегами по лаборатории по единой общелабораторной тематике.

Я надеюсь, что сказанным выше я уже убедил читателей в том, что зависимость вида х —α, несмотря на разнообразие величин α, весьма характерна для распределений, описывающих индивидуальную результативность внутри не слишком малых устойчивых сообществ ученых, работающих в одном институте или одной научной области. Следует подчеркнуть, что распределения результативности среди ученых, скажем, подающих заявки на гранты или, тем более, выигравших их, могут значительно отличаться от х —α ввиду преодоления последними отбора по определенным критериям (возраст, количество опубликованных статей, размер коллектива заявителей). Многократное различие в индивидуальной продуктивности или результативности ученых, располагающихся на левой и правой сторонах распределения, не является особенностью российских научных институтов, — это универсальная тенденция, наблюдаемая в мировой науке в целом на протяжении по меньшей мере последних 90 лет.

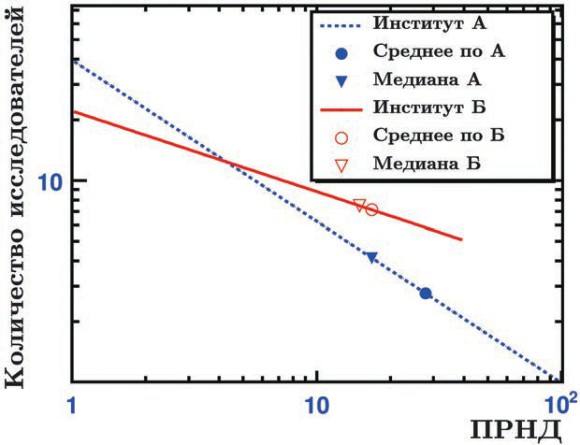

Следующий пример наглядно демонстрирует абсурдность сравнения эффективности работы научных учреждений путем сравнения средних показателей, вычисляемых для каждого института в целом. Рассмотрим характеристики двух гипотетических институтов, назовем их «институт А» и «институт Б», продуктивность сотрудников в которых характеризуется степенными зависимостями х —α с показателями α = 0,8 и 0,4 соответственно (см. рис. 2). Предположим, что в институтах А и Б работает по 300 сотрудников, а диапазоны их ПРНД (x) составляют соответственно от 1 до 100 и от 1 до 40. При указанных параметрах распределений средние значения ПРНД составят для А и Б 27,8 и 16,8 соответственно. Следуя критериям ФАНО и Минобрнауки, опирающимся на сравнение средних значений по институтам, институт А должен быть однозначно признан более результативным по сравнению с институтом Б. Однако даже с первого взгляда видно, что отмеченными на рис. 2 средними значениями ПРНД невозможно охарактеризовать научные коллективы в целом. Действительно, всего несколько сотрудников из трехсот в институтах А и Б имеют значения ПРНД близкие к средним по соответствующему научному учреждению. Более того, из рис. 2 видно, что начиная со значения ПРНД равного 4 количество сотрудников в более «слабом» (по определению ФАНО и Минобрнауки!) институте Б превышает количество сотрудников с аналогичной результативностью в институте А. Общее число сотрудников, имеющих ПРНД более 4, в институте А составляет 237, а в более «слабом» институте Б — 252! Высокая степень сотрудничества научных работников, однородность тематики и методики проводящихся исследований, единство научной школы института Б могут давать более равномерное распределение результативности с меньшим α. Тем не менее, следуя абсурдным критериям ФАНО и Минобрнауки, институт А однозначно должен быть признан лучшим по отношению к Б исключительно на основе среднего ПРНД его коллектива. Однако только при условии схожести тем и областей исследований в А и Б небольшое число сотрудников с ПРНД превышающим 40 действительно можно рассматривать как неоспоримое преимущество института А. Нельзя исключить ситуацию, когда трудоемкость и ресурсоемкость проводимых институтом Б исследований сужают диапазон ПРНД сотрудников и их формальной результативности, но это не ставит под сомнение значимость их научных результатов. Следует подчеркнуть, что сопоставление медианных значений ПРНД институтов А и Б (см. рис. 2) аналогично сопоставлению средних и ведет к тем же ошибочным выводам.

Обобщая сказанное, можно сделать следующие выводы. Во-первых, совершенно недопустимо делить институты на успешно работающие или отстающие исключительно на основе сравнения их средних или медианных показателей, вычисленных по всему научному коллективу. Похожий вывод сделан в упомянутой выше работе [10] относительно степенной зависимости числа цитирований. Там подчеркивается, что среднее число цитирований статьи не может описать всё многообразие распределения работ по числу их цитирований, а различия между средними и медианными значениями оказываются значительны.

Во-вторых, следует понимать и правильно интерпретировать разнообразие формальных показателей результативности сотрудников каждого института, которые сильно зависят от характера научной деятельности, решаемых задач, используемых методов, научной среды, инфраструктуры, в которой ведутся исследования. Для оценки институтов ФАНО следует обратить внимание прежде всего на конкретные результаты работающих в них научных групп, лабораторий и даже отдельных ученых, высшие достижения каждого института, его уникальность и авторитет в мировой науке.

В-третьих, объединение институтов ФАНО в большие научные центры только усложнит оценку эффективности. Диапазон результативности сотрудников в каждом таком большем центре в силу многообразия научных тем и областей будет огромен, поэтому сравнение средних показателей крупных научных центров тем более становится бессмысленным.

В завершение скажу, что я не призываю усложнить ФСМНО, дополнив ее анализом распределения результативности сотрудников внутри каждого научного учреждения на основе начисления каждому сотруднику баллов, вычисления ПРНД, персональных рейтингов. Подобные системы не раз подвергались обоснованной критике [11], поскольку их использование в сфере научного творчества создает неблагоприятный климат в научных коллективах, мешает работать, вынуждает сотрудников подстраиваться под формальную систему оценок, расфасовывать результаты по многочисленным коротким статьям и докладам на малозначительных конференциях. ФСМНО, в принципе, содержит полезные статистические данные, однако ее следует рассматривать исключительно в качестве вспомогательного инструмента оценки институтов, а не в качестве ориентира для проведения поспешных реформ в научной сфере.

- Сойфер В. Россия без РАН.

- www.sciencemon.ru/

- http://fano.gov.ru/ru/activity/assessment/index.php

- Онищенко Е. Новое — плохо забытое старое.

- Фейгельман М., Чеботарев П. Blitzkrieg завершен, объявлен Neuordnung.

- Ловушка для институтов ФАНО.

- http://sovet-po-nauke.ru/info/05022015-press-release

- www.poisknews.ru/theme/ran/15928/?print

- Lotka A.J. The frequency distribution of scientific productivity // J. Wash. Acad. Sci. 16 (1926). 317.

- Lehmann S. et al. Citation networks in high energy physics // Phys. Rev. E 68 (2003). 026113.

- Грановский Ю. Не в ту степь. О персональных рейтингах научных сотрудников Московского университета.

Дошло до того, что вузы формально нанимают исследователей из научных институтов (в основном РАН), чтобы повысить формальные показатели кафедр. Голимое очковтирательство!

Давненько не брал я в руки шашек…О начале реформы. реформа революционная. как говаривал Маркс, дело революции быстро гибнет, когда его отдают в руки профессоров и юристов.Реформе уже два года, а кроме дешевого «тявканья» от академиков и иже с ними ничего не слышно. Статья очень интересная. Но почему она написана? ФАНО дало всем хорошего пинка. Увы, пинок не бывает интеллигентным. Но только после него человек начинает думать. Объединять институты надо. И не для науки, а для того чтобы уничтожить местечковое мракобесие, которое в них расцвело пышным цветом. Наверное Дубна исключение, но в в московских НИИ директор-князь и царь в одном лице.Один из таких мракобесов искал недавно у крыс душу.Это, конечно крайность, но тиражирование многие годы одной тематики , или как у нас принято школы, тоже мракобесие.Насчет предыдущего комментария. и правильно делают. Еще крестьянин говаривал:чей бы бычок не прыгал, а теленочек наш.А вообще лучший президент академии- Ковальчук. Он хоть и жириновский от науки, зато не боится ничего нового

Дубна не исключение. А мракобесия сейчас не меньше, а скорее больше чем в СССР.

Отсылаю желающих узнать кое-что интересное

о ранжировании научных сотрудников

к своей статье в ж. «Путь науки» №10 за 2015г

(она найдется в Ине-те или на сайте ИФА РАН в списке публикаций).

Так вот, индексы -индексами,

а без открытого научного доклада по итогам 10-15 лет работы,

вы не сможете дать правильную оценку деятельности ученого.

И Такую оценку может дать

типичный добротный Ученый совет того НИИ,

где аттестуемый человек отработал эти 10-15 лет.

Пусть Уч совет потратит 1-1.5 часа

на прослушивание доклада (на Уч совете)

и оценит предъявленные результаты по единой для всех НИИ

согласованной и утвержденной шкале ценностей

(типа той, что я предлагал в упомянутой статье).

И все.

Че-к как на ладони.

Дел-то всего 1/4 раб. дня на 1 н.с.

На 100 н. сот-ков в НИИ потребуется около 50 заседаний,

т.к. более двух «боливар» не вынесет….

Тут уж ничего не поделаешь, экспертиза называется…

Но и это — всего лишь 1 год работы.

А мы болтаем уже 3-4 года (а то и 90 лет, как указано в статье выше)

и конец этому не виден.

Российская наука — самая передовая

http://izvestia.ru/news/610461

у науки и образования рф в целом перспективы печальные ибо нет экономики которая в них нуждается ибо советское наследие уже почти разрущено и разграблено за 25 лет нынешней власти